CoCreate AI hat maßgeblich zur Transformation unserer Dateninfrastruktur beigetragen. Dank der reibungslosen Integration von Echtzeit-Streaming und Analytics gewinnen wir heute wertvollere Einblicke als je zuvor. Gleichzeitig wurden unsere Systeme optimal für die Expansion in neue Märkte aufgestellt – skalierbar, effizient und zukunftsfähig.

Global Head of Data - DigiHaul Ltd.

In einer datengetriebenen Welt bildet eine leistungsfähige Infrastruktur die Grundlage dafür, Daten in echten geschäftlichen Mehrwert zu verwandeln. Ganz gleich, ob Sie Datensilos aufbrechen, Echtzeit-Analysen realisieren oder Ihre Prozesse skalieren möchten – wir entwickeln maßgeschneiderte End-to-End-Data-Engineering-Lösungen, die genau auf Ihre Anforderungen abgestimmt sind.

Datenplattformen müssen mit Ihrem Unternehmen mitwachsen. Wir entwickeln skalierbare Architekturen, die steigende Datenmengen, neue Anwendungsfälle und zusätzliche Nutzer problemlos bewältigen. Ob Sie neue Märkte erschließen, interne Prozesse ausweiten oder Ihr Produktportfolio erweitern – unsere Lösungen lassen sich flexibel anpassen, ohne die Performance zu beeinträchtigen. So bleiben Sie technologisch und geschäftlich jederzeit zukunftsfähig.

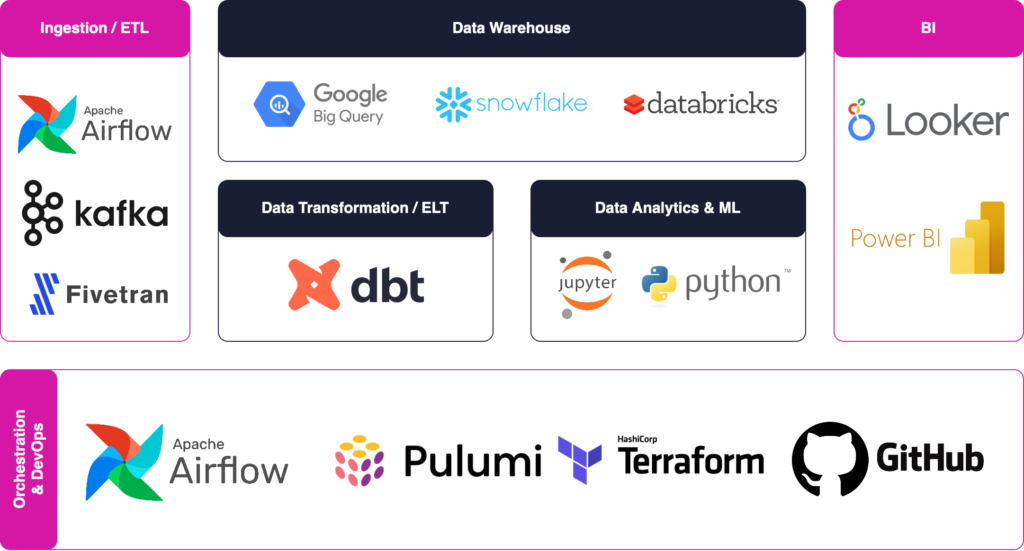

Bei CoCreate AI erstellen wir nicht nur Datenpipelines, sondern auch umfassende, skalierbare Datenplattformen, die auf Ihre Geschäftsanforderungen zugeschnitten sind. Unser Ansatz integriert die Schlüsselkomponenten des modernen Data Engineering: Ingestion, Speicherung, Transformation, Orchestrierung und Governance. Wir stellen sicher, dass Ihre Dateninfrastruktur zuverlässig und effizient ist und sowohl den aktuellen Betrieb als auch zukünftiges Wachstum unterstützen kann.

Eine robuste Datenplattform beginnt mit nahtlosen, zuverlässigen Datenerfassung aus einer Vielzahl von Quellen. Wir entwickeln Pipelines, die alles von strukturierten Datenbanken (SQL, ERP-Systeme) bis hin zu unstrukturierten Daten (Logs, IoT-Streams, Social Media Feeds) verarbeiten. Unsere Lösungen unterstützen sowohl Stapelverarbeitung für große, periodische Datenmengen und Dank der reibungslosen Integration von Echtzeit-Streaming und Analytics gewinnen wir heute wertvollere Einblicke als je zuvor. mit Tools wie Apache Kafka, Fivetran, oder AWS Kinesis.

Unabhängig davon, ob wir APIs, Altsysteme oder Datenanbieter von Drittanbietern integrieren, stellen wir sicher, dass die Daten konsistent und sicher in Ihre Plattform fließen. Wir lösen auch wichtige Herausforderungen bei der Datenübernahme wie Datendeduplizierung, Latenzzeitverkürzungund FehlerbehandlungDadurch wird sichergestellt, dass Ihre Datenpipelines sowohl effizient als auch widerstandsfähig sind.

Einmal aufgenommene Daten brauchen ein sicheres, skalierbares Zuhause. Wir bauen Data Warehouses und Daten-Seen die auf die Bedürfnisse Ihres Unternehmens zugeschnitten sind, und nutzen Cloud-native Lösungen wie Schneeflocke, Google BigQuery, Amazon Redshift, oder Azure Synapse-Analytik. Unsere Architekturen sind darauf ausgelegt, große Datenmengen zu speichern und gleichzeitig die hohe Leistung und Kosteneffizienz.

Wir helfen Ihnen bei der Umsetzung Datenpartitionierung, Clusteringund Kompression Strategien zur Optimierung der Abfrageleistung, sei es für betriebliche Berichte oder erweiterte Analysen. Je nach Ihren geschäftlichen Anforderungen integrieren wir auch hybride Speicherlösungen, die das Beste aus strukturierten (Data Warehouse) und unstrukturierten (Data Lake) Umgebungen kombinieren und Flexibilität und Skalierbarkeit ermöglichen.

Rohdaten kommen selten in einem analysefähigen Format an. Wir entwerfen Datenumwandlung Prozesse, die Ihre Daten bereinigen, anreichern und standardisieren, um sie zuverlässig weiterzuverwenden. Mit Tools wie dbt (Datenerstellungstool), Apache Spark, oder SQL-basierte ELT-FrameworksWir stellen sicher, dass Ihre Daten korrekt und konsistent sind und mit der Geschäftslogik übereinstimmen.

Unsere Transformationen umfassen alles von Datenbereinigung (Behandlung fehlender Werte, Deduplizierung) zu komplexe Verbindungenund Anwendungen für Geschäftsregeln. Durch die Automatisierung dieser Prozesse reduzieren wir den manuellen Aufwand, gewährleisten die Reproduzierbarkeit und machen Ihre Datenanalyse bereit für BI-Werkzeuge, Dashboardsund Workflows für maschinelles Lernen.

Die Verwaltung komplexer Daten-Workflows erfordert eine präzise Orchestrierung und Automatisierung. Wir implementieren Orchestrierungstools wie Apache Airflow, Präfekt, oder Dagster um Ihre Datenpipelines zu planen, zu überwachen und zu automatisieren. Diese Tools stellen sicher, dass die Daten nahtlos von der Aufnahme über die Speicherung bis zur Umwandlung weitergeleitet werden, mit klaren Abhängigkeiten und Fehlerbehandlung bei jedem Schritt.

Unsere Orchestrierungsstrategien umfassen Wiederholungsmechanismen, Ausfallwarnungenund Pipeline-Versionierungund bietet Transparenz und Kontrolle über Ihre Daten-Workflows. Dies reduziert den betrieblichen Aufwand und stellt sicher, dass die Daten immer frisch und verfügbar sind, wenn Sie sie brauchen, sei es für tägliche Berichte oder Echtzeitanalysen.

Verlässliche Daten sind die Grundlage für eine effektive Entscheidungsfindung. Wir implementieren umfassende Rahmen für die Datenqualität zur Überwachung, Validierung und Bereinigung Ihrer Daten in jeder Phase der Pipeline. Tools wie Große Erwartungen oder Deequ ermöglichen automatisierte Tests, die sicherstellen, dass die Daten den Qualitätsstandards entsprechen, bevor sie die Endnutzer erreichen.

Neben der Qualität bieten wir auch detaillierte Datenherkunft und Metadatenmanagement Lösungen. Indem wir nachverfolgen, woher die Daten kommen, wie sie umgewandelt werden und wohin sie fließen, verschaffen wir Ihren Teams die Transparenz, die sie für Compliance, Reproduzierbarkeit und Governance benötigen. Egal, ob Sie sich an die GDPR, HIPAAUnsere Lösungen sorgen dafür, dass Ihre Daten sicher, überprüfbar und vertrauenswürdig bleiben.

Sobald Ihre Daten bereinigt, umgewandelt und gespeichert sind, müssen sie für die richtigen Teams und Tools zugänglich sein. Wir sorgen für eine nahtlose Integration mit gängigen BI-Plattformen wie Tableau, Power BIund LookerWir bieten Self-Service-Funktionen, die es Geschäftsanwendern ermöglichen, Daten unabhängig zu erforschen. Für Data Science- und Machine Learning-Teams optimieren wir die Datenbereitstellung für Plattformen wie Datenbausteine, AWS SageMaker, oder Google Vertex AI.

Wir setzen auf eine sichere, rollenbasierte Zugangskontrolle und implementieren Datenkataloge um den Teams das Auffinden und die Nutzung der benötigten Daten zu erleichtern, ohne die Governance zu beeinträchtigen. So wird sichergestellt, dass Ihre Dateninfrastruktur sowohl die strategische Entscheidungsfindung auf höchster Ebene als auch granulare, erweiterte Analyse-Workflows unterstützt.

Analyse & Strategie: Wir starten mit einem tiefgehenden Verständnis Ihrer Geschäftsziele und identifizieren jene KI-Potenziale, die den größten strategischen Impact bieten.

Konzeption & Entwicklung: Wir entwickeln maßgeschneiderte KI-Lösungen, die auf Ihre Bedürfnisse zugeschnitten sind, wobei wir uns auf Skalierbarkeit, Integration und messbare Ergebnisse in der Praxis konzentieren.

Betrieb & Support: Wir begleiten Ihre Lösung über den Launch hinaus: Wir sorgen dafür, dass Ihre KI-Systeme in der Produktion reibungslos laufen, indem wir sie kontinuierlich unterstützen.

Kontinuierliche Weiterentwicklung: Mit Ihrem Unternehmen wachsen auch Ihre Anforderungen. Wir sorgen dafür, dass Ihre KI-Lösungen flexibel bleiben – durch laufendes Monitoring, regelmäßige Updates und datenbasiertes Re-Training.